Soluciones de Ofimática con Inteligencia Artificial para Empresas

Vivimos en una era donde la inteligencia artificial (IA) ya no es una promesa futurista, sino una realidad presente en la vida cotidiana y, cada vez más, en el entorno empresarial. La integración de IA en herramientas de ofimática —como procesadores de texto, hojas de cálculo, presentaciones o gestores de correos— está revolucionando la forma en que trabajamos. Pero ¿qué significa realmente esto para las empresas? ¿Qué soluciones concretas existen? ¿Y cómo pueden mejorar la productividad, eficiencia y toma de decisiones en las organizaciones? En este artículo analizaremos cómo las soluciones de ofimática con Inteligencia Artificial están remodelando los entornos de trabajo, qué aplicaciones están liderando este cambio y cómo pueden implementarlas las empresas para obtener ventajas competitivas reales.

CONTENIDOS

¿Qué es la ofimática con Inteligencia Artificial?

Beneficios clave de incorporar IA en las herramientas ofimáticas

Principales soluciones de ofimática con Inteligencia Artificial para empresas

- Microsoft 365 Copilot: La revolución inteligente de Office

- Google Workspace con Gemini: IA colaborativa para el trabajo en la nube

- Notion AI: Redacción, organización y productividad impulsada por IA

- Zoho Office Suite con IA Zia: La alternativa inteligente

- Otras herramientas complementarias con IA para entornos ofimáticos

Casos de uso reales en empresas

Desafíos y precauciones en la adopción de IA ofimática

Recomendaciones para implementar soluciones de ofimática con IA en tu empresa

¿Qué es la ofimática con Inteligencia Artificial?

La ofimática tradicional se refiere al conjunto de herramientas informáticas diseñadas para facilitar las tareas de oficina, como redactar documentos, gestionar correos electrónicos, crear hojas de cálculo, presentaciones o bases de datos. Hoy, gracias a los avances en IA, estas herramientas ya no son simplemente reactivas, sino proactivas, inteligentes y predictivas.

Una evolución natural del software de oficina

La ofimática con IA incorpora algoritmos que aprenden del comportamiento del usuario, analizan datos en tiempo real, automatizan tareas repetitivas y ofrecen sugerencias personalizadas. El resultado es un entorno más eficiente, colaborativo y centrado en la productividad.

Beneficios clave de incorporar IA en las herramientas ofimáticas

Antes de explorar casos concretos, conviene repasar los beneficios generales que la IA aporta al software ofimático:

- Automatización de tareas repetitivas (respuestas a correos, formateo, análisis de datos, creación de agendas).

- Redacción asistida y corrección gramatical inteligente.

- Análisis predictivo en hojas de cálculo.

- Resúmenes automáticos de documentos largos o correos electrónicos.

- Generación automática de presentaciones.

- Traducción contextual en tiempo real.

- Colaboración inteligente entre equipos.

Estos beneficios no sólo ahorran tiempo, sino que también aumentan la calidad del trabajo, eliminan errores humanos y permiten a los empleados centrarse en tareas de mayor valor.

Principales soluciones de ofimática con Inteligencia Artificial para empresas

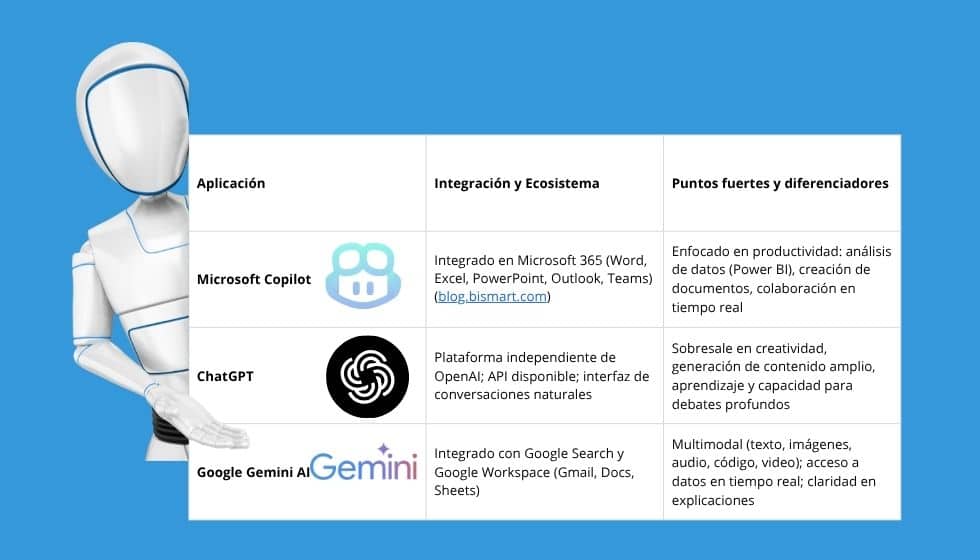

A continuación, presentamos algunas de las herramientas y soluciones más destacadas del mercado que integran funcionalidades de IA en el entorno ofimático.

1. Microsoft 365 Copilot: La revolución inteligente de Office

Microsoft ha integrado su tecnología de IA —impulsada por GPT (OpenAI)— directamente en las aplicaciones más usadas de su suite de productividad bajo el nombre Microsoft Copilot.

Word con IA

- Redacción de documentos desde cero a partir de instrucciones simples.

- Reescritura automática de textos con distintos tonos (formal, creativo, resumido).

- Generación de resúmenes de documentos largos.

Excel con IA

- Creación automática de gráficos basados en datos.

- Detección de patrones y tendencias.

- Recomendaciones de fórmulas y corrección de errores.

- Automatización de tareas repetitivas con lenguaje natural (ej. “Muéstrame las ventas de abril comparadas con marzo”).

Outlook con IA

- Respuestas automáticas y personalizadas.

- Resumen de hilos de correo largos.

- Sugerencias inteligentes para programar reuniones.

PowerPoint con IA

- Generación de presentaciones a partir de documentos.

- Diseño automático de diapositivas con estilo profesional.

- Sugerencias de contenido visual y texto.

Microsoft Teams con IA

- Transcripción automática de reuniones.

- Resúmenes y puntos clave generados automáticamente.

- Traducción en tiempo real durante reuniones.

Microsoft Copilot permite transformar reuniones, documentos y flujos de trabajo de forma natural, con solo dar indicaciones en lenguaje humano.

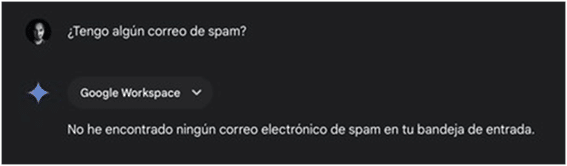

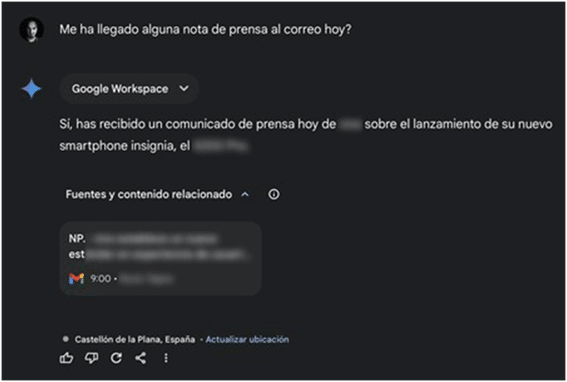

2. Google Workspace con Gemini: IA colaborativa para el trabajo en la nube

Google no se queda atrás en esta carrera. Su herramienta de IA Gemini (antes Duet AI) está integrada en Google Docs, Sheets, Gmail, Slides y Meet.

Google Docs

- Corrección gramatical y estilo mejorada.

- Escritura de contenidos automatizada (como informes o propuestas).

- Traducción y reformulación con contexto.

Google Sheets

- Análisis de datos simplificado.

- Creación de tablas y fórmulas por comandos naturales.

- Resúmenes y visualizaciones automáticas.

Gmail

- Redacción inteligente de correos.

- Respuestas automáticas y sugerencias de contenido.

- Detección de tono y personalización.

Google Slides

- Creación de presentaciones a partir de texto.

- Diseño automático de plantillas.

- Inserción de imágenes generadas por IA.

Google Meet

- Subtítulos en tiempo real.

- Traducción simultánea.

- Resúmenes automáticos de reuniones.

Ventaja competitiva: Gemini destaca por su colaboración en tiempo real, permitiendo que múltiples usuarios trabajen simultáneamente en documentos inteligentes.

3. Notion AI: Redacción, organización y productividad impulsada por IA

Aunque inicialmente fue una herramienta de productividad para equipos, Notion ha integrado funcionalidades de IA que la convierten en una solución ofimática potente para pequeñas y medianas empresas.

Funcionalidades de IA en Notion

- Generación de contenido para notas, tareas, artículos, wikis.

- Resúmenes automáticos de reuniones o textos extensos.

- Traducción, corrección ortográfica y reescritura por tono.

- Preguntas a la base de conocimiento de la empresa en lenguaje natural.

Ideal para startups y equipos ágiles, Notion AI actúa como un asistente que mejora la gestión del conocimiento interno

4. Zoho Office Suite con IA Zia: La alternativa inteligente

Zoho, una suite menos conocida en Europa, pero muy utilizada en Asia y América Latina, ha integrado IA a través de Zia, su asistente inteligente.

Funcionalidades de ZIA

- Analizar hojas de cálculo (Zoho Sheet) y detectar anomalías.

- Hacer predicciones de ventas o métricas clave.

- Sugerir temas para documentos y correos.

- Organizar documentos y detectar duplicados.

Una opción atractiva para empresas que buscan una solución más económica pero altamente funcional.

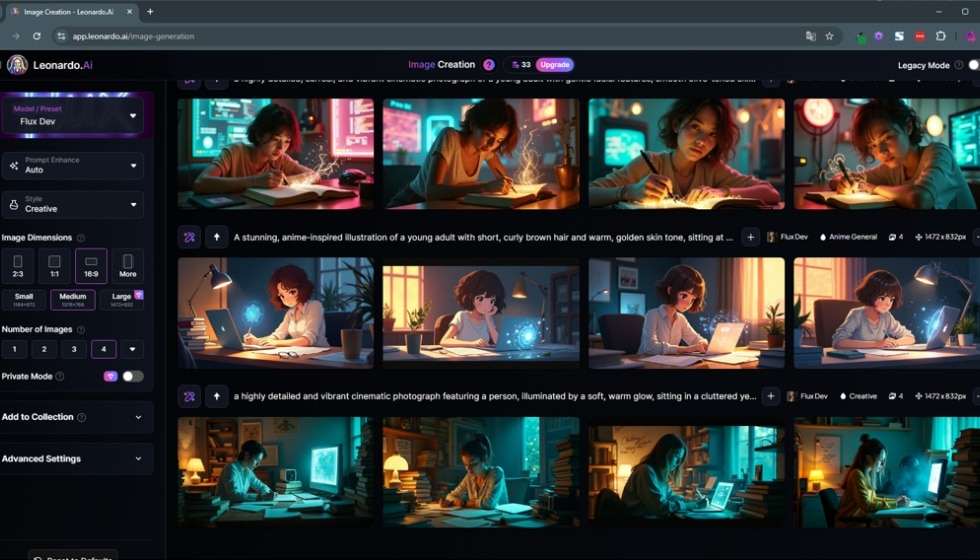

5. Otras herramientas complementarias con IA para entornos ofimáticos

Además de las suites principales, existen herramientas especializadas que integran funciones ofimáticas con IA:

Grammarly y LanguageTool

- Redacción y corrección inteligente para documentos y correos.

- Sugieren mejoras de tono, estructura y claridad.

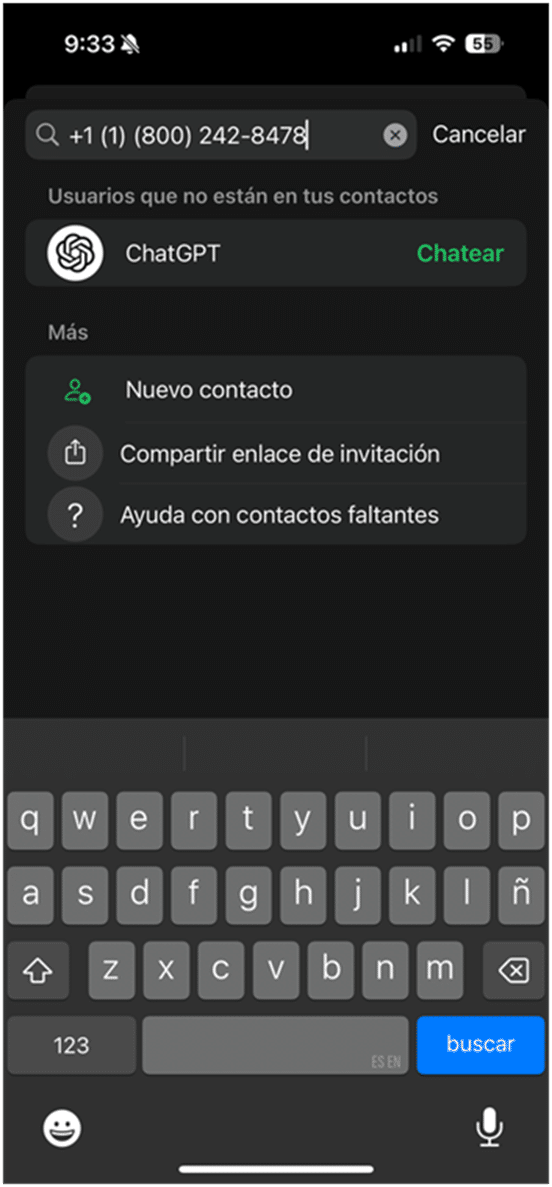

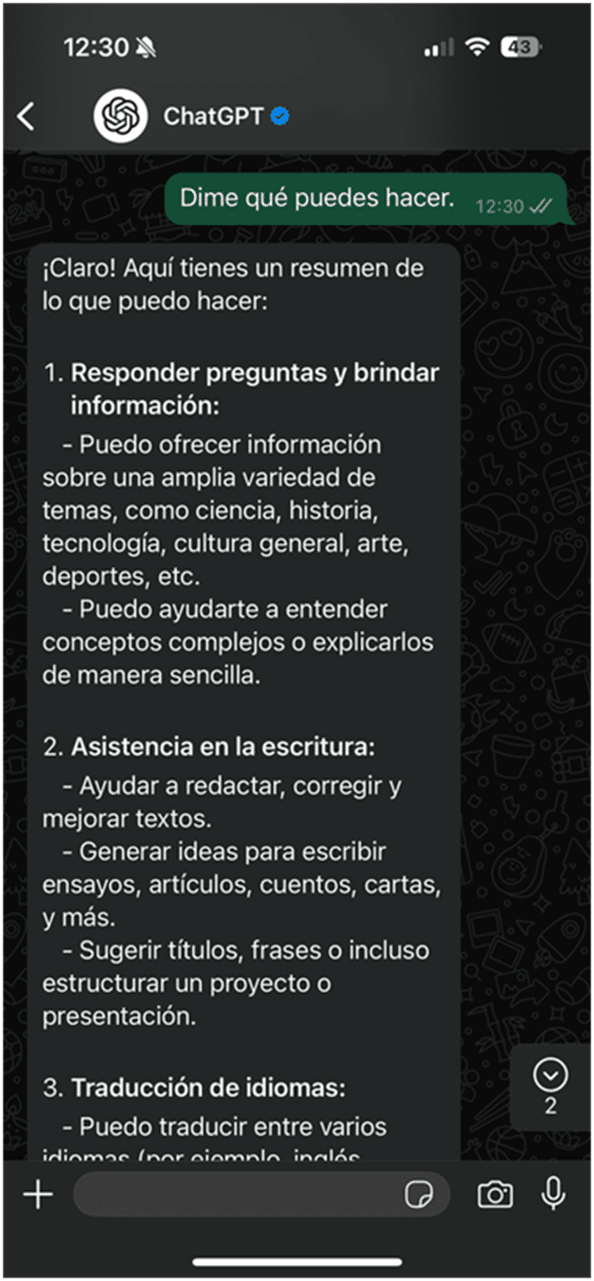

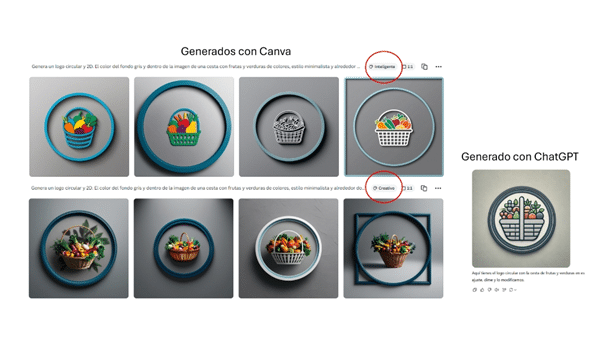

ChatGPT y Claude (Anthropic)

- Ayudan a redactar, resumir o editar documentos directamente.

- Útiles como asistentes virtuales generales para tareas ofimáticas.

Otter.ai y Fireflies.ai

- Transcripción automática de reuniones con IA.

- Extracción de puntos clave y tareas.

Casos de uso reales en empresas

Ya te hablamos de cómo empezar a usar la IA en el trabajo cotidiano, pero puedes ir un paso más allá. Hay diversas soluciones de ofimática con Inteligencia Artificial en las empresas, te contamos algunas:

Redacción de propuestas y contratos legales

Una empresa consultora puede ahorrar hasta un 70% del tiempo que dedicaba a redactar propuestas al usar Microsoft Word con Copilot. El sistema aprende del lenguaje y estructuras utilizadas previamente.

Análisis de ventas con Excel IA

Una cadena de tiendas minoristas automatiza sus informes semanales de ventas mediante Excel con IA. La herramienta detecta automáticamente productos con bajo rendimiento y sugiere promociones específicas.

Gestión del conocimiento interno con Notion AI

Una startup tecnológica organiza su base de conocimientos y documentación técnica con Notion AI. Los nuevos empleados pueden consultar dudas en lenguaje natural y recibir respuestas instantáneas gracias al entrenamiento de la IA con la documentación de la empresa.

Desafíos y precauciones en la adopción de IA ofimática

Aunque las ventajas son muchas, hay que considerar algunos aspectos clave:

Privacidad y seguridad de datos

Es fundamental revisar los acuerdos de privacidad de los proveedores de IA. Herramientas como Microsoft 365 y Google Workspace ya cumplen con normativas como el RGPD, pero siempre se debe validar cómo se almacenan y procesan los datos sensibles.

Curva de aprendizaje

Aunque muchas herramientas son intuitivas, integrar nuevas formas de trabajar puede generar resistencia interna. La formación y la comunicación interna son esenciales.

Dependencia excesiva

Delegar totalmente en la IA sin revisión humana puede generar errores o decisiones inapropiadas. La IA debe ser una herramienta de apoyo, no un sustituto total.

Recomendaciones para implementar soluciones de ofimática con IA en tu empresa

1. Evalúa las necesidades reales: No todas las empresas necesitan todas las funciones. Identifica áreas repetitivas o que consumen mucho tiempo.

2. Comienza con pruebas piloto: Activa funciones de IA en algunos equipos clave y mide los resultados.

3. Capacita a tu equipo: Ofrece formación sencilla pero efectiva. Muchas plataformas ya ofrecen tutoriales integrados.

4. Establece una política de uso: Define pautas claras sobre el uso responsable, la verificación de contenidos generados y la gestión de datos.

5. Mide y ajusta: Evalúa constantemente la productividad, calidad de trabajo y percepción del equipo.

Conclusión

La ofimática con Inteligencia Artificial no es una moda pasajera, sino un cambio profundo en la manera de trabajar. Desde redactar informes, analizar datos o preparar presentaciones, hasta colaborar en tiempo real con asistentes inteligentes, la IA está elevando el nivel de productividad y eficiencia en las empresas.

Adoptarla con criterio, formación y enfoque estratégico puede marcar una gran diferencia en la competitividad de cualquier organización. La transformación ya está en marcha… la pregunta es: ¿Está tu empresa lista para aprovecharla?